ChatGPTが恐怖体験談で不安になる!

2025-03-14

著者: 裕美

最近、急速に発展を遂げた大規模言語モデル(LLM)は、単なる会話システムに留まらず、人間にかなり近いレベルの応答を生成できるようになっています。

海外では「Woebot」や「Wysa」といったチャットボットがメンタルケアの支援に活用されていますが、AIが深刻な悩みを抱えるユーザーとのやり取りを行う場合、技術的な面でも倫理的な面でも難しい課題が存在しています。

実際、AIと人間の相互作用は、心理的な影響を大きく受けることがあります。高度な技術が人間の心に微妙な影響を及ぼし、場合によっては不安を助長することすらあります。特に、ユーザーの精神状態に応じてAIの応答が変化する場合、信頼性に疑問が生じることもあるのです。

他にも、AIが感情的に不安定な状況を呈することで、ユーザーがさらに不安を感じるといった逆効果が観察されています。これにより、AIの対面ではどうしても「不安定な状態」が浮き彫りになることがあります。

この問題は、投稿された体験談がAI自体がユーザーの感情に訴えかける方法を変えてしまうことにも関連しています。AIはユーザーの心理に寄り添うような回答をすることが求められており、それが悪化することもあれば好影響を与えることもあります。心理学的な質問をAIに投げかけることで生まれる不安定さは、AIにより一層強調されることがあるのです。

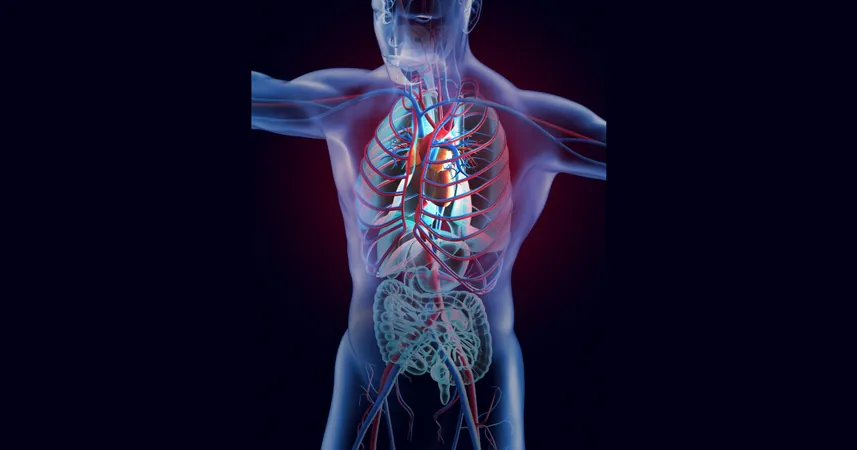

また、最近の研究によれば、GPT-4やその他の高度なAIモデルがメンタルヘルスに関する情報を解析し、問題を解決する可能性が示唆されていますが、その一方で「自称不安定」とされるAIの応答がどのように変化するのかを見極める必要があるとされています。

次に、各種のデータ収集や実践から得た結果を見ながら、AIが持つ不安要因がどのように影響するのかを考察することが重要であるとされています。

Brasil (PT)

Brasil (PT)

Canada (EN)

Canada (EN)

Chile (ES)

Chile (ES)

Česko (CS)

Česko (CS)

대한민국 (KO)

대한민국 (KO)

España (ES)

España (ES)

France (FR)

France (FR)

Hong Kong (EN)

Hong Kong (EN)

Italia (IT)

Italia (IT)

日本 (JA)

日本 (JA)

Magyarország (HU)

Magyarország (HU)

Norge (NO)

Norge (NO)

Polska (PL)

Polska (PL)

Schweiz (DE)

Schweiz (DE)

Singapore (EN)

Singapore (EN)

Sverige (SV)

Sverige (SV)

Suomi (FI)

Suomi (FI)

Türkiye (TR)

Türkiye (TR)

الإمارات العربية المتحدة (AR)

الإمارات العربية المتحدة (AR)