In che modo l'intelligenza artificiale potrebbe presto superare quella umana?

2024-10-10

Autore: Maria

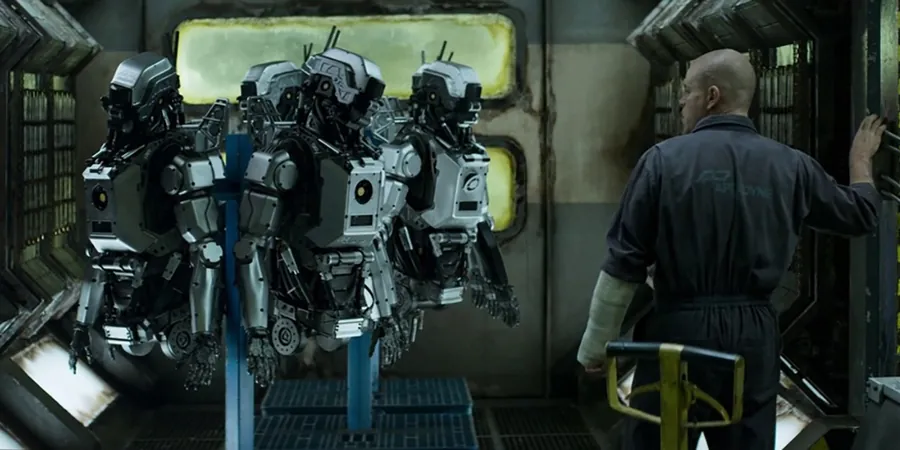

A giugno, durante una diretta su X, Elon Musk, imprenditore statunitense, ha affermato che nel lungo periodo i robot umanoidi supereranno numericamente gli esseri umani, raggiungendo un rapporto di 10 a 1. Questa previsione, che Musk condivide da tempo, è alimentata da altri esponenti nel settore tecnologico e teorici dell'intelligenza artificiale, i quali avvertono delle conseguenze potenzialmente inimmaginabili per l'economia globale.

Il dibattito sul superamento dell'intelligenza umana da parte di quella artificiale è altamente divisivo. Le incomprensioni sorgono non solo per una definizione variabile del termine "intelligenza", ma anche per le differenti interpretazioni delle potenzialità tecnologiche. Come nel caso delle criptovalute, le posizioni sono influenzate da interessi economici e aspettative di mercato, complicando ulteriormente il confronto.

Uno degli esperti più noti nel campo è Shane Legg, neozelandese e co-fondatore di DeepMind, una società di intelligenza artificiale acquistata da Google nel 2014. Legg ha contribuito a definire il concetto di intelligenza artificiale generale (AGI), la cui esistenza è prevista da diversi scienziati. Nel 2011, Legg aveva stimato una probabilità del 50% che un'intelligenza artificiale di livello umano sarebbe esistita entro il 2028. Questa stima è stata ripresa anche da Sam Altman, CEO di OpenAI, nel 2023, anno in cui diversi esperti hanno denunciato il rischio esistenziale legato all'AI, paragonandolo a minacce globali come pandemie e conflitti nucleari.

Nonostante alcuni firmatari di una lettera aperta su questi rischi siano stati accusati di ipocrisia per continuare a finanziare ricerche nel campo dell'AI, lo scenario complessivo resta preoccupante. Ciò solleva interrogativi su possibili conflitti di interesse e sulla vera motivazione dietro tali avvertimenti.

Recentemente, un giovane analista tedesco, Leopold Aschenbrenner, ha pubblicato un report sui progressi previsti dell'AI nei prossimi dieci anni, descrivendo l'abilità del deep learning di svolgere compiti assimilabili a quelli di ricercatori e ingegneri. Aschenbrenner ha suggerito che entro il 2027, i modelli AI potrebbero addirittura autonomamente migliorarsi, cosa che ha sollevato scetticismo tra gli esperti. Inoltre, ha messo in luce il problema dell'enorme richiesta di energia necessaria per alimentare tali sistemi, prevenendo quindi molti ottimismi infondati riguardo ai progressi immediati.

Alcuni scienziati, come la fisica tedesca Sabine Hossenfelder, affermano che mentre l'AGI ha il potere di apportare progresso scientifico, la sua realizzazione rimane una questione di grande complessità e di lungo termine. L'AGI potrebbe migliorare la nostra comprensione scientifica e ridurre gli errori umani nel ragionamento, ma gli ostacoli tecnologici e energetici restano significativi.

Un sondaggio condotto su oltre 2.700 ricercatori ha rivelato che la maggior parte non prevede un'imminente capacità dell'AI di superare gli esseri umani in ogni compito. Tuttavia, per il 50% degli intervistati, l'AI finirà per eguagliare l'intelligenza umana entro il 2047.

In definitiva, il dibattito si concentra non solo sui progressi tecnologici, ma anche su ciò che significhi veramente "intelligenza". Mentre l'intelligenza artificiale continua a evolversi, il futuro delle interazioni tra umani e macchine suscita domande fondamentali su etica, responsabilità e la natura stessa della coscienza. In questo contesto, occorrerà quindi riflettere su come integrare queste tecnologie nel tessuto sociale affinché possano effettivamente migliorare la nostra vita quotidiana piuttosto che contribuire ad un impoverimento delle opportunità lavorative.

Brasil (PT)

Brasil (PT)

Canada (EN)

Canada (EN)

Chile (ES)

Chile (ES)

España (ES)

España (ES)

France (FR)

France (FR)

Hong Kong (EN)

Hong Kong (EN)

Italia (IT)

Italia (IT)

日本 (JA)

日本 (JA)

Magyarország (HU)

Magyarország (HU)

Norge (NO)

Norge (NO)

Polska (PL)

Polska (PL)

Schweiz (DE)

Schweiz (DE)

Singapore (EN)

Singapore (EN)

Sverige (SV)

Sverige (SV)

Suomi (FI)

Suomi (FI)

Türkiye (TR)

Türkiye (TR)